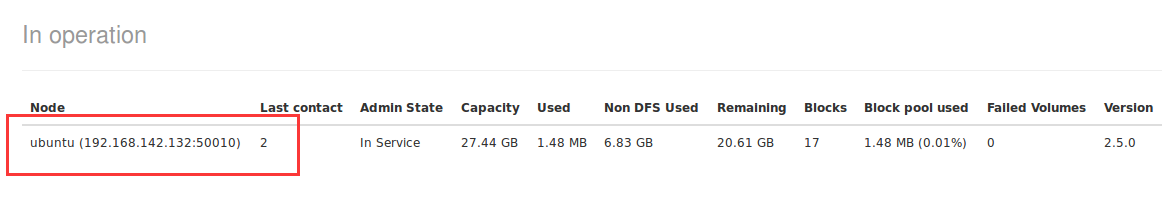

hadoop小象 发表于 2015-5-9 11:42 1、hdfs-site.xml中设置replication的数目,你有几个准备的datanode,就设置为对应的值 2、查看hostname是否设置正确,错误的话映射不到对应的节点 3、按照最后结贴的内容,查看下datanode的html页面,如下只启动了一个datanode  这个页面显示的信息无误才可以继续往下走 4、配置了yarn.nodemanager.resource.memory-mb这个配置项,你把值改大些 希望对你有帮助~! |

| 我也遇到这问题了,只前跑过没什么问题,你是怎么解决的,replication:datanode在哪配置? |

|

运行成功,出来结贴~!希望可以给遇到同样问题的论坛朋友一个参考。(自己的想法,有错的地方希望大神们可以指出来,以免给别人带来错误的参考) 1、master:50070界面虽然显示"live nodes: 2",但实际上进去datanode页面查看,只有一个节点的信息,这个时候集群是非正常启动的,需要重新修改配置文件。所以集群启动成功与否,看datanode界面的响应的节点信息。 2、在修改完“/etc/hosts”文件之后,主机名其实还没有变化,需要在”etc/hostname“文件中进一步修改,如”ubuntu(原始的名称) ---> 你指定的hostname“,,然后重新开一个命令窗口,看@后面的字段是不是更新了,如果没更新,建议你重启一下机器 3、在找错的过程中,看到,yarn框架中你有几个datanode,就要将”replication:datanode数目“字段设置为对应数目 4、在求解的过程中,感谢langke93,desehawk大神的细心解答,谢谢~! |

roant 发表于 2015-1-19 20:36 只有提供了这些信息,才能帮助你解决问题 |

langke93 发表于 2015-1-19 20:18 在等待的期间,根本就没有任何的 WARN 或者 ERROR 信息(namenode和datanode上的logs我都查看了),无从下手才来问的~~! |

roant 发表于 2015-1-19 19:44 继续看日志和报错 |

roant 发表于 2015-1-19 18:25 |

roant 发表于 2015-1-19 18:25 host混乱了,仔细检查程序。找到Ubuntu是从那来的 |

/2

/2