|

本帖最后由 pig2 于 2016-11-13 20:35 编辑 第六题:( ip, page)是默认日志字段,楼主根据自己的情况,酌情修改。 加载数据,字段是自己文件的内容,这里只指定了,ip和page grunt> A = LOAD '/opt/access_log.txt' USING PigStorage (' ') AS ( ip, page); grunt> DESCRIBE A; A: {ip: bytearray,page: bytearray} 去掉用不着的信息 grunt> B = FOREACH A GENERATE ip; 分组 grunt> C = GROUP B BY ip; grunt> DESCRIBE C; C: {group: bytearray,B: {(ip: bytearray)}} 统计 grunt> D = FOREACH C GENERATE group AS ip, COUNT(B) AS count; 输出路径 STORE D INTO '/opt/output' USING PigStorage(); |

|

本帖最后由 starrycheng 于 2016-11-11 15:26 编辑 第五题:Local 模式又分3中方式,楼主可以试试默认使用第一种即可 pig –x local 更多 ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~ 1.Local 模式: ( 1 ) Grunt Shell 方式 用户使用 Grunt Shell 方式时,需要首先使用命令开启 Pig 的 Grunt Shell ,只需在 Linux 终端中输入如下命令并执行即可: $pig –x local 这样 Pig 将进入 Grunt Shell 的 Local 模式,如果直接输入“ $pig ”命令, Pig 将首先检测 Pig 的环境变量设置,然后进入相应的模式。如果没有设置 MapReduce 环 境变量, Pig 将直接进入 Local 模式。 Grunt Shell 和 Windows 中的 Dos 窗口非常类似,这里用户可以一条一条地输入命令对数据进行操作。 ( 2 ) 脚本文件方式 使用脚本文件作为批处理作业来运行 Pig 命令,它实际上就是第一种运行方式中命令的集合,使用如下命令可以在本地模式下运行 Pig 脚本: $pig –x local script.pig 其中,“ script.pig ”是对应的 Pig 脚本,用户在这里需要正确指定 Pig 脚本的位置,否则,系统将不能识别。例如, Pig 脚本放在“ /root/pigTmp ”目录下,那 么这里就要写成“ /root/pigTmp/script.pig ”。用户在使用的时候需要注意 Pig 给出的一些提示,充分利用这些能够帮助用户更好地使用 Pig 进行相关的操作 。 ( 3 ) 嵌入式程序方式 我们可以把 Pig 命令嵌入到主机语言中,并且运行这个嵌入式程序。和运行普通的 Java 程序相同,这里需要书写特定的 Java 程序,并且将其编译生成对应的 class 文 件或 package 包,然后再调用 main 函数运行程序。用户可以使用下面的命令对 Java 源文件进行编译: $javac -cp pig-*.*.*-core.jar local.java 这里“ pig-*.*.*-core.jar ”放在 Pig 安装目录下,“ local.java ”为用户编写的 java 源文件,并且“ pig-*.*.*-core.jar ”和“ local.java ”需要用户正确地指定相应的 位置。例如,我们的“ pig-*.*.*-core.jar ”文件放在“ /root/hadoop-0.20.2/ ”目录下,“ local.java ”文件放在“ /root/pigTmp ”目录下,所以这一条命令我们应 该写成:$javac -cp /root/hadoop-0.20.2/ pig- 0 . 20 . 2 -core.jar /root/pigTmp/ local.java当编译完成后, Java 会生成“ local.class ”文件,然后用户可以通过 如下命令调用执行此文件。 $ java -cp pig-*.*.*-core.jar:. Local ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~ |

452156740 发表于 2016-11-11 14:51 第四题:这个题可能存在问题。查看hadoop所有路径,还是所在路径。所有路径的可能性不大。查所在路径还是可以的。这个问题暂时保留,你可以问问老师。 如果是所在路径,可以尝试下面命令 内表:使用这个命令 show create table tablename 外表尝试下面命令 describe database databasename; |

|

第三题: hbase创建表xiandian带有两个列簇 create 'xiandian',address','info' |

|

第二题: 我这没有环境,只能手敲了 在hdfs上创建chinaskills bin/hadoop fs -mkdir /chinaskills 上传文件chinaskills.txt hadoop fs -put chinaskills.txt /chinaskills 检测文件是否损坏 hadoop fsck /chinaskills |

|

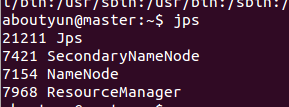

本帖最后由 starrycheng 于 2016-11-11 14:37 编辑 这些很常见的,楼主搜一下应该就有的 第一题:命令都是jps,关键是截图 master有如下进程:  slave1有如下进程  参考 hadoop(2.x)以hadoop2.2为例完全分布式最新高可靠安装文档 http://www.aboutyun.com/forum.php?mod=viewthread&tid=7684 |

/2

/2