阿飞 发表于 2018-9-21 15:03 嗯嗯。谢谢。 |

|

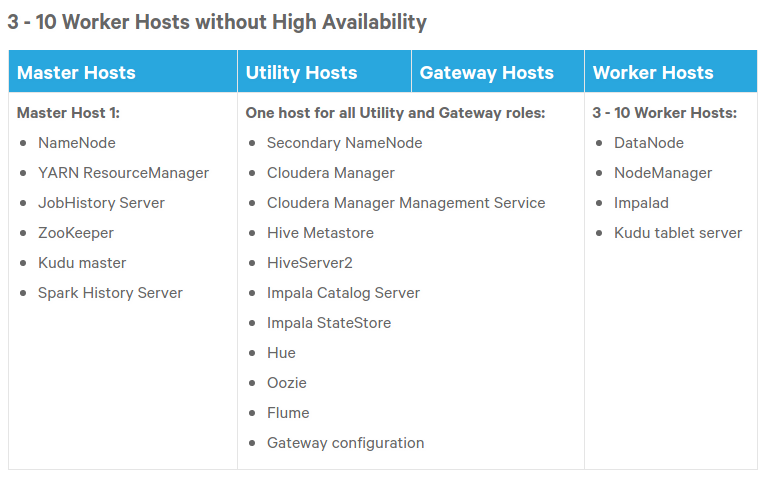

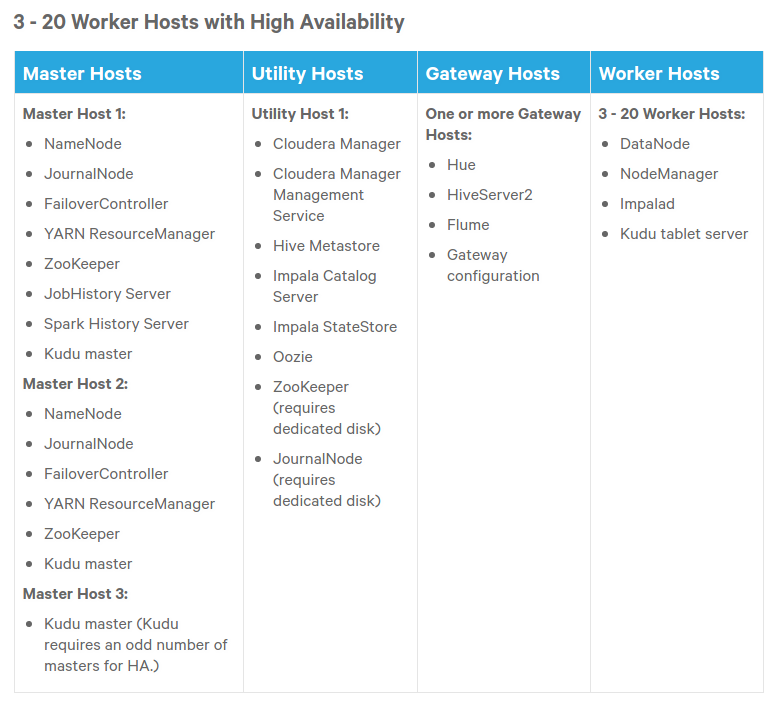

0、需求 现在Mysql已经有很多数据,比如会员数据、商品数据、订单数据等等,我想对这些数据进行分析,比如分析会员增长趋势、分析订单客单价等。 还有Nignx访问日志,用户行为日志数据,我想对这些日志进行分析。 日志分析建议参考: about云日志分析,而且已经录制成视频: http://www.aboutyun.com/forum.php?mod=group&fid=139 1、组件选择 基于以上需求,我应该选择哪些组件呢?Hive、Hbase、Spark、Zookeeper? 如果选择最少的组件,是不是只需要Hive就可以了?如果再从性能、速度、功能考虑,还需要添加哪些组件比较好呢? 出现这个问题,说明了解的大数据知识太少了,而且不能一概而论,需要结合你的具体业务。这方面需要专业人员帮助你来分析。 2、硬盘分区方案 硬盘怎么分区会比较合适?分多少个区?以及大小怎么规划比较好?比如/、/data? 主要是考虑到安装CM需要的空间、数据存储的位置以及空间、日志存放位置以及大小、各个组件的目录等。 4、节点分配 按照官方文档的推荐,有2种看起来比较适合我的情况,对于5台机器,大家有无什么好的建议? 刚开始可以不用HA,对于下面也只是组件的选择,没有什么合适不合适的,还是需要了解你的大数据框架,你要干什么、   |

clixiang 发表于 2018-9-20 21:41 如果不了解,别人也只是根据经验去描述,没有绝对正确,楼主如果想搭建集群,建议有经验的人。 也可以加入咱们的微信w3aboutyun,进微信群交流。 |

s060403072 发表于 2018-9-20 19:33 收到回复,太感动啦。 我重新描述了下我的问题。 |

|

1、组件选择 我应该选择哪些组件呢?Hive、Hbase、Spark、Zookeeper。 这些跟你的架构方案有关系,下面架构可参考 hadoop 2.6.5 + spark 1.6.3 + kafka 0.9.0.1 + flume 1.6.0 + hive 1.2.1 + scala 2.11.8【修改为2.10】 更多参考: about云日志分析项目准备5:hadoop,spark,kafka,flume,hive等工具的版本选择 http://www.aboutyun.com/forum.php?mod=viewthread&tid=20587 2、硬盘分区方案 硬盘怎么分区会比较合适?分多少个区?以及大小怎么规划比较好?比如/、/data? 这个分区,参考普通的Linux即可 推荐参考 https://blog.csdn.net/explore_world/article/details/79081587 3、内存 内存的话,我打算1台32G(CM以及Mysql),其他4台每台16G。合理不? 这个可以暂时这么分配,主机master内存可以多一些。后期根据需要在调整 |

/2

/2