和咱们VIP老马经常讨论问题,这次这个问题有点让我意外。也没想到spark2挺人性化的,对于随机端口提供了范围的限制。

如何指定Spark2作业中Driver和Executor使用指定范围内端口那?按照下面操作

配置Spark Driver和Executor端口范围

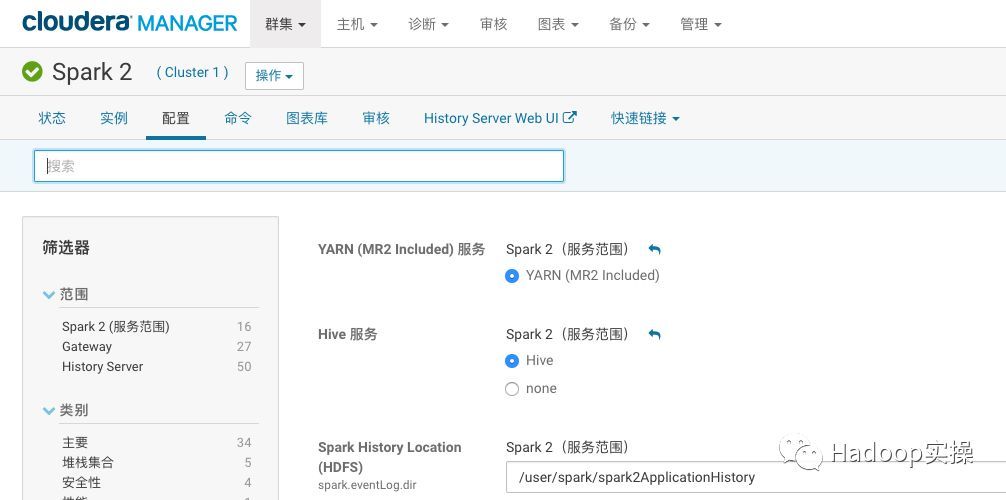

1.登录到CM管理界面,进入Spark服务的配置界面

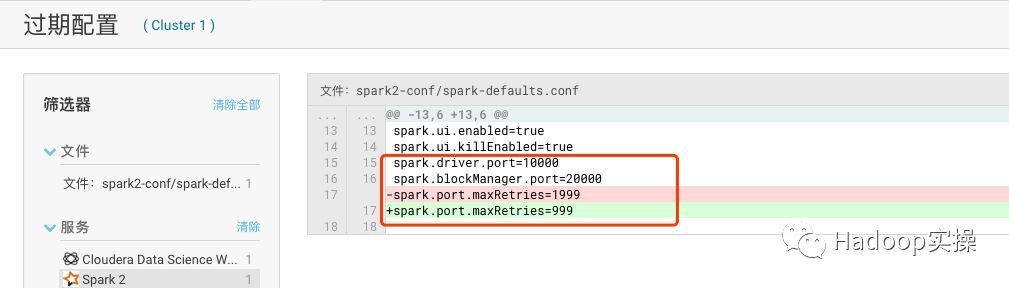

2.在Gateway分类中配置也搜索“spark-defaults.conf”,添加如下配置: spark.driver.port=10000spark.blockManager.port=20000spark.port.maxRetries=999

(可左右滑动)

3.保存配置,并重新部署Spark2的客户端配置

参考

https://cloud.tencent.com/developer/article/1349474

|  /2

/2