本帖最后由 nettman 于 2015-4-16 22:41 编辑

问题导读

1.StandardAnalyzer有什么优点和缺点?

2.基于Lucene的第三方中文分词是什么技术?

3.IKAnalyzer分词技术有什么缺点?

4.你使用过哪些分词技术?

接上篇

基于lucene的案例开发5:搜索索引

在lucene创建索引的过程中,数据信息的处理是一个十分重要的过程,在这一过程中,主要的部分就是这一篇博客的主题:分词器。在下面简单的demo中,介绍了7中比较常见的分词技术,即:CJKAnalyzer、KeywordAnalyzer、SimpleAnalyzer、StopAnalyzer、WhitespaceAnalyzer、StandardAnalyzer、IKAnalyzer;自己可以通过注释的形式一一验证。源程序如下:

Analyzer分词demo

- /**

- *@Description: 分词技术demo

- */

- package com.lulei.lucene.study;

-

- import java.io.StringReader;

-

- import org.apache.lucene.analysis.Analyzer;

- import org.apache.lucene.analysis.TokenStream;

- import org.apache.lucene.analysis.cjk.CJKAnalyzer;

- import org.apache.lucene.analysis.core.KeywordAnalyzer;

- import org.apache.lucene.analysis.core.SimpleAnalyzer;

- import org.apache.lucene.analysis.core.StopAnalyzer;

- import org.apache.lucene.analysis.core.WhitespaceAnalyzer;

- import org.apache.lucene.analysis.standard.StandardAnalyzer;

- import org.apache.lucene.analysis.tokenattributes.CharTermAttribute;

- import org.apache.lucene.util.Version;

- import org.wltea.analyzer.lucene.IKAnalyzer;

-

- public class AnalyzerStudy {

-

- public static void main(String[] args) throws Exception {

- //需要处理的测试字符串

- String str = "这是一个分词器测试程序,希望大家继续关注我的个人系列博客:基于Lucene的案例开发,这里加一点带空格的标签 LUCENE java 分词器";

- Analyzer analyzer = null;

- //标准分词器,如果用来处理中文,和ChineseAnalyzer有一样的效果,这也许就是之后的版本弃用ChineseAnalyzer的一个原因

- analyzer = new StandardAnalyzer(Version.LUCENE_43);

- //第三方中文分词器,有下面2中构造方法。

- analyzer = new IKAnalyzer();

- analyzer = new IKAnalyzer(false);

- analyzer = new IKAnalyzer(true);

- //空格分词器,对字符串不做如何处理

- analyzer = new WhitespaceAnalyzer(Version.LUCENE_43);

- //简单分词器,一段一段话进行分词

- analyzer = new SimpleAnalyzer(Version.LUCENE_43);

- //二分法分词器,这个分词方式是正向退一分词(二分法分词),同一个字会和它的左边和右边组合成一个次,每个人出现两次,除了首字和末字

- analyzer = new CJKAnalyzer(Version.LUCENE_43);

- //关键字分词器,把处理的字符串当作一个整体

- analyzer = new KeywordAnalyzer();

- //被忽略的词分词器

- analyzer = new StopAnalyzer(Version.LUCENE_43);

-

- //使用分词器处理测试字符串

- StringReader reader = new StringReader(str);

- TokenStream tokenStream = analyzer.tokenStream("", reader);

- tokenStream.reset();

- CharTermAttribute term = tokenStream.getAttribute(CharTermAttribute.class);

- int l = 0;

- //输出分词器和处理结果

- System.out.println(analyzer.getClass());

- while(tokenStream.incrementToken()){

- System.out.print(term.toString() + "|");

- l += term.toString().length();

- //如果一行输出的字数大于30,就换行输出

- if (l > 30) {

- System.out.println();

- l = 0;

- }

- }

- }

- }

注:上述程序对analyzer进行了9次赋值,自己可以通过一一注解的形式查看每一种分词技术的分词效果。

分词器介绍

下面将会对这些分词器做一些简单的介绍,以及上述程序在该分词器下的运行截图:

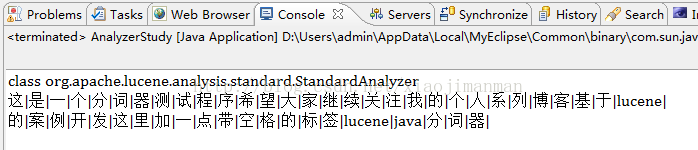

StandardAnalyzer

StandardAnalyzer标准分词器,如果用来处理中文,和ChineseAnalyzer有一样的效果,这也许就是之后的版本弃用ChineseAnalyzer的一个原因。用StandardAnalyzer处理英文效果还不错,但是对中文的处理只是将其分成单个汉字,并不存在任何语义或词性,如果实在没有其他的分词器,用StandardAnalyzer来处理中文还是可以的,上述事例使用StandardAnalyzer分词技术的运行结果如下图:

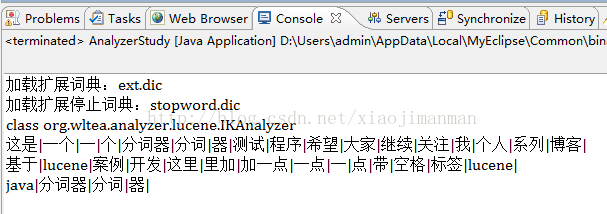

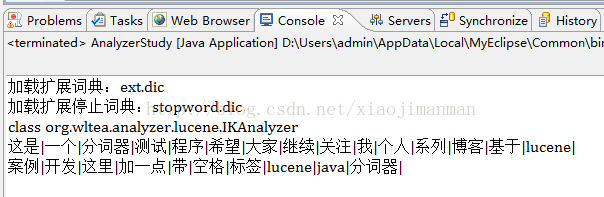

IKAnalyzer

IKAnalyzer是基于Lucene的第三方中文分词技术,该分词技术基于现有的中文词库实现的,在构造Analyzer对象时有两种构造方法,无参构造等同于new IKAnalyzer(false) ,在介绍true/false两种参数下分词器的不同之前先看看这两种情况下的事例运行结果:

false运行结果如下图:

true运行结果如下图:

从上述事例中,我们可以简单的看出,false的情况下会对已分的词进行再分,如果存在长度较小的词元,也将其作为一个分词结果。IKAnalyzer是一种比较常用的中文分词技术,但是其分词效果过于依赖字典,所以要使其达到更好的效果,需要不断的升级自己的字典。

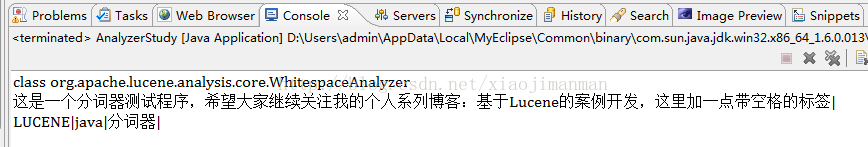

WhitespaceAnalyzer

WhitespaceAnalyzer空格分词,这个分词技术就相当于按照空格简单的切分字符串,对形成的子串不做其他的操作,结果同string.split(" ")的结果类似。上述事例在WhitespaceAnalyzer分词技术下的运行结果如下图:

这种分词技术也许你会绝对没有太大的作用,它对输入的字符串几乎没有做太多的处理,对语句的处理结果也不是太好,如果这样想就错了,下面就简单的想一下这个问题,这篇博客的标签是 lucene、java、分词器,那这三个词在索引中又该如何的存储,采用何种分词技术呢?这里不做任何解答,自己思考下,在以后的小说案例中会对标签这个域提出具体的解决方案。

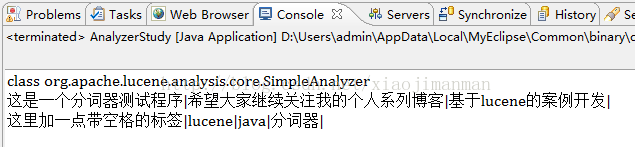

SimpleAnalyzer

SimpleAnalyzer简单分词器,与其说是一段话进行分词,不如说是一句话就是一个词,遇到标点、空格等,就将其之前的内容当作一个词。上述事例在SimpleAnalyzer分词技术下的运行结果如下图:

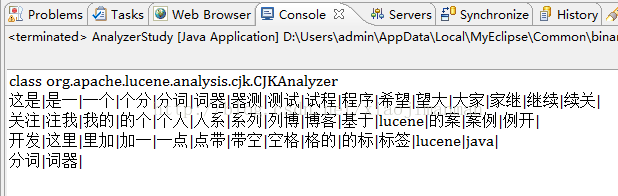

CJKAnalyzer

CJKAnalyzer是二分法分词器,这个分词方式是正向退一分词(二分法分词),同一个字会和它的左边和右边组合成一个次,每个人出现两次,除了首字和末字,也就是说会将任何两个相邻的汉字当作是一个词,这种分词技术会产生大量的无用词组。上述事例在CJKAnalyzer分词技术下的运行结果如下图:

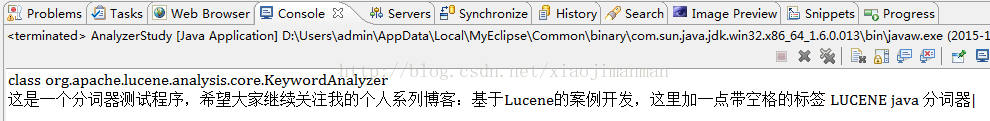

KeywordAnalyzer

KeywordAnalyzer关键字分词器,把处理的字符串当作一个整体,这个分词器,在lucene之前的版本中或许还有点作用,但最近的几个版本中,Lucene对域的类型做了细分,它的作用就不是太大了,不做在luke中,还是相当重要的。上述事例在KeywordAnalyzer分词技术下的运行结果如下图:

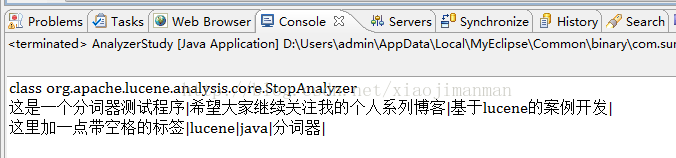

StopAnalyzer

StopAnalyzer被忽略的词分词器,被忽略的词就是在分词结果中,被丢弃的字符串,如标点、空格等。上述事例在StopAnalyzer分词技术下的运行结果如下图:

上述的7种分词技术都可以对中文做处理,对外文(非英语)的处理有以下几种分词技术:

BrazilianAnalyzer 巴西语言分词

CzechAnalyzer 捷克语言分词

DutchAnalyzer 荷兰语言分词

FrenchAnalyzer 法国语言分词

GermanAnalyzer 德国语言分词

GreekAnalyzer 希腊语言分词

RussianAnalyzer 俄罗斯语言分词

ThaiAnalyzer 泰国语言分词

相关内容:

基于lucene的案例开发1:lucene初始认知

基于lucene的案例开发2:索引数学模型

基于lucene的案例开发3:索引文件结构

基于lucene的案例开发4:创建索引

基于lucene的案例开发5:搜索索引

基于lucene的案例开发6:分词器介绍

基于lucene的案例开发7:Query查询

基于lucene的案例开发8:IndexSearcher中检索方法

基于lucene的案例开发9:案例初识

基于lucene的案例开发10:搜索后台基础,JsonUtil & XmlUtil类介绍

基于lucene的案例开发11:项目常用类ClassUtil & CharsetUtil介绍

基于lucene的案例开发12:数据库连接池

基于lucene的案例开发13:实现实时索引基本原理

基于lucene的案例开发14:实时索引管理类IndexManager

基于lucene的案例开发15:实时索引的检索

基于lucene的案例开发16:实时索引的修改

基于lucene的案例开发17:查询语句创建PackQuery

基于lucene的案例开发18:纵横小说更新列表页抓取

基于lucene的案例开发19:纵横小说简介页采集

基于lucene的案例开发20:纵横小说章节列表采集

基于lucene的案例开发21:纵横小说阅读页采集

出处:http://blog.csdn.net/xiaojimanman/article/details/42836309 |  /2

/2