|

本帖最后由 yuwenge 于 2015-5-9 20:58 编辑

问题导读

1.Spring Boot是什么?

2.Lattice 用来做什么的项目?

3.利用 Spring Boot 在 Docker 中运行 Hadoop需要哪些条件?

简介

越来越多的应用都开始使用Hadoop框架。而开发者在使用过程中也遇到一些挑战,比如使用诸如Docker之类的容器开发和部署相关的技术栈开发的应用。我们将会在下面的例子中介绍如何克服这些挑战。

由于 Spring 框架一直以来致力于从开发者角度对底层基础设施进行抽象,我们选择 Spring Boot 来进行开发。下面将会利用 Spring Boot 的配置文件来管理多容器的部署。

在下面第一部分,我们将应用部署在一个 Docker 容器内,在第二部分我们将会利用 Lattice 平台提供的功能进行部署。

在容器中运行 Spring Boot 应用

Docker 是一个构建、部署以及运行应用的开放平台,应用可以在不同的环境(开发、测试、生产)中无差别的运行,为应用的开发提供了很大的灵活性。

Lattice 是一个运行容器化工作负载的开源项目,通过它可以在集群中运行 Docker 化的应用。该平台的目标是在未来支持蓝绿部署、容量伸缩以及连接诸如日志服务的其它服务。

Spring Boot是由Pivotal团队提供的全新框架,其设计目的是用来简化新Spring应用的初始搭建以及开发过程。

我们将会介绍如何通过 Spring Boot 在 Docker 上运行简单的 Hadoop 任务,并且在第二部分利用 Lattice 来扩展这个例子。

Spring Boot 应用将会访问 Hadoop 集群(在一个容器中运行的微型集群),运行 Map/Reduce 任务,并访问 HDFS。

运行这个例子需要下面这些依赖条件以及一些基础标准工具(SSH等)

下面是大概的步骤:

- 在容器中运行 Hadoop

- git clone 示例代码

- 组装 JAR 包

- Docker 化应用

- 在 Docker 容器中部署应用

确保 Docker 正在运行,你可以通过下面的命令来重启 Docker:

[mw_shl_code=applescript,true]boot2docker restart[/mw_shl_code]

在容器中运行 Hadoop

运行下面的命令,将会从 Docker 仓库中下载 sequenceiq 提供的 Hadoop 2.6.0 镜像,接下来将容器以后台程序运行(命令行 -d 参数)并且启动一个交互式 bash shell (命令行 -ti 参数):

[mw_shl_code=applescript,true]docker exec -ti $(docker run -d sequenceiq/hadoop-docker:2.6.0) /bin/bash[/mw_shl_code]

接下来我们对容器进行一些改动。在命令行运行下面的命令,首先记录运行 Hadoop 的容器 IP 地址:

/sbin/ifconfig eth0 | grep 'inet addr:' | cut -d: -f2 | awk '{ print $1}'

将会显示下面的内容,这个 IP 地址之后会被用到。

[mw_shl_code=shell,true]172.17.02[/mw_shl_code]

启动任务历史服务器,该服务默认没有启动,并利用下面的命令增加输入文件:

[mw_shl_code=shell,true]export PATH=$PATH:/usr/local/hadoop/bin

/usr/local/hadoop/sbin/mr-jobhistory-daemon.sh start historyserver

hadoop fs -mkdir /tmp

hadoop fs -chmod 1777 /tmp

hadoop fs -mkdir -p /tmp/hadoop-yarn/staging/history

hadoop fs -chmod -R 777 /tmp/hadoop-yarn

hadoop fs -mkdir -p /user/root/example/input

hadoop fs -mkdir -p /user/vcap/example/input

cat > /tmp/simple.txt<<EOF

able was i ere i saw elba

a quick brown fox jumped over the lazy dog

i came i saw i conquered

the rain in spain stays mainly in the plain

EOF

hadoop fs -put /tmp/simple.txt /user/root/example/input/simple.txt

hadoop fs -put /tmp/simple.txt /user/vcap/example/input/simple.txt

hadoop fs -chown -R root /user/root

hadoop fs -chown -R vcap /user/vcap

exit[/mw_shl_code]

返回到宿主机。

git clone 样例代码

如果你只是想部署一个应用,那么这一步和下一步都可以忽略了,但是如果你想将应用打包,那么继续!

在宿主机的终端输入下面的命令:

[mw_shl_code=shell,true]git clone https://github.com/emccode/big-data-techcon-2015[/mw_shl_code]

组装 JAR 包

现在你已经准备好了利用 Maven 来组装 JAR。由于 Maven 需要将所有的依赖下载到本地,第一次需要花费一些时间。

[mw_shl_code=shell,true]cd big-data-techcon-2015/hello-cloud/

mvn clean package[/mw_shl_code]

Docker 化应用

在这一步我们将应用 Docker 化:

[mw_shl_code=shell,true]docker build -t hello-cloud .

docker tag -f hello-cloud ragsns/hello-cloud[/mw_shl_code]

我们现在可以将其部署到一个 Docker 容器中。

在 Docker 容器中部署应用

首先确认已经将 hadoop_host 替换成上面得到的地址,接下来利用下面的命令运行 Spring Boot 应用的 Docker 容器。这将会从本地仓库运行 Docker 应用,如果本地没有找到回去中心仓库下载,即我们忽略了应用构建的过程。

[mw_shl_code=shell,true]docker run -d -p 8080 -e sping_profiles_active=docker -e hadoop_host=172.17.0.2 ragsns/hello-cloud[/mw_shl_code]

命令会返回运行 Spring Boot 应用的容器 ID,类似于下面的模样:

7d6d35f26272d1379ea9881dd5e885268006562593c7f73b0a28881518ba4ec6

利用下面的命令获取运行 Spring Boot 应用容器的 IP 地址,你可以指定完整的 ID 或者 ID 的前几个字母:

[mw_shl_code=shell,true]docker inspect --format '{{ .NetworkSettings.IPAddress }}' 7d6d3[/mw_shl_code]

你将会得到类似于下面的结果:

[mw_shl_code=shell,true]172.17.0.12[/mw_shl_code]

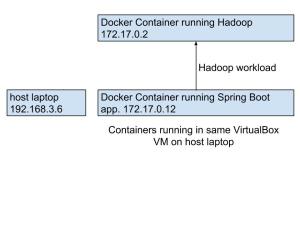

下图展示了配置的过程。在这里的宿主机是一台 Mac 所有的容器都运行在高度优化后的 VirtualBox VM 中,在这里是 Boot2Docker VM。如果你在 Linux 机器中运行样例的话,那么你的 Docker 容器直接运行在宿主机之上。

运行下面的命令:

docker ps

对于这个容器你会看到类似于下面的输出:

[mw_shl_code=shell,true]0.0.0.0:49160->8080/tcp

[/mw_shl_code]

这意味着 Boot2Docker VM 上的 49106 端口双向转发容器 8080 端口的流量。如果运行下面的命令:

[mw_shl_code=shell,true]curl -L "$(boot2docker ip):49160"[/mw_shl_code]

你将会看到 Spring Boot 应用中运行的输出结果:

Hello Hadoop!

根据上面的 IP,你可以通过下面的 URL 链接来利用浏览器访问 Spring Boot 应用。

运行下面的命令:

boot2docker ip

将会看到类似下面的输出:

192.168.59.104

这个应用共有 5 个也页面,最后两个将会和 Hadoop 容器产生交互。将下面的链接加到前面的 ip 和端口后面即可访问。

- / Hello 信息

- /env 环境变量

- /ip IP 地址

- /fspath 浏览 HDFS

- /wc 运行 word count 这个 MapReduce 样例

举例来说 http://192.168.59.104:49160/ 会展示 Hello 信息,http://192.168.59.104:49160/env/ 会展示环境变量。也可以加入新的路由来直接使用容器的 IP 地址,我们将在下一部分进行介绍。

总结我们在上面的例子中介绍如何利用 Spring Boot 在 Docker 中运行 Hadoop 任务。我们利用 Spring Boot 解决开发中的问题,利用 Docker 解决测试和部署方面的问题。

完整的代码可以在这里获得 https://github.com/emccode/big-data-techcon-2015。

原文链接:Hadoop workloads in Docker with Spring Boot (翻译:刘梦馨 校对:宋喻 )

|

|

/2

/2