链接: https://pan.baidu.com/s/184-ycG0bdVxp4FjjMNdhPg 提取码: 9mad

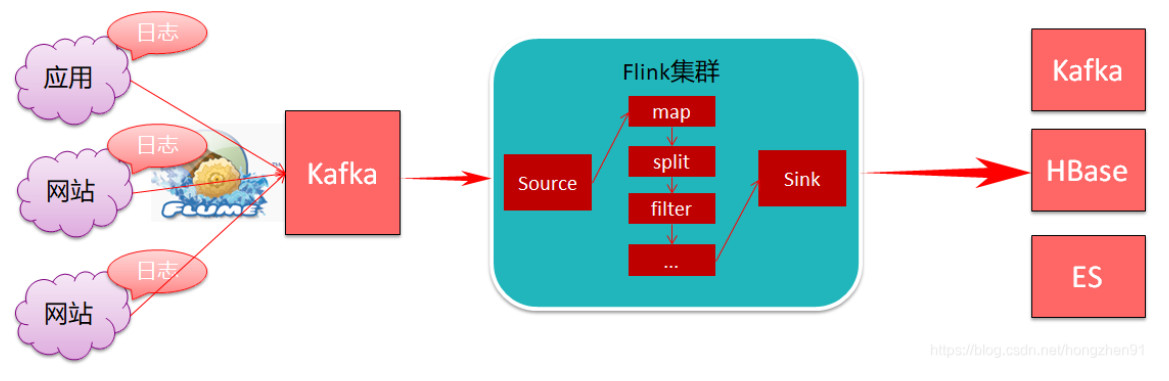

FlinkProj 案例开发应用场景:

1、数据清洗【实时ETL】

1.1、需求分析针对算法产生的日志数据进行清洗拆分

- 算法产生的日志数据是嵌套大JSON格式(json嵌套json),需要拆分打平

- 针对算法中的国家字段进行大区转换

- 最后把不同类型的日志数据分别进行存储

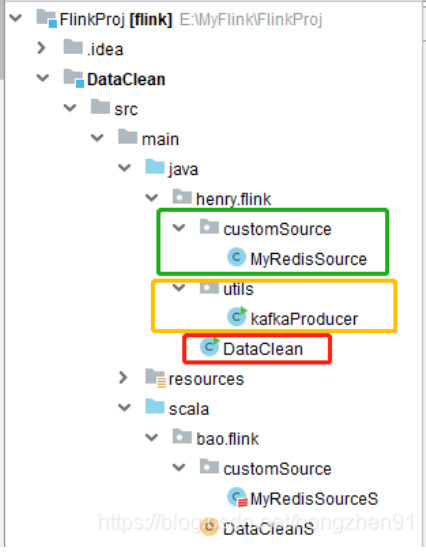

1.2、数据清理 DataClean 结构

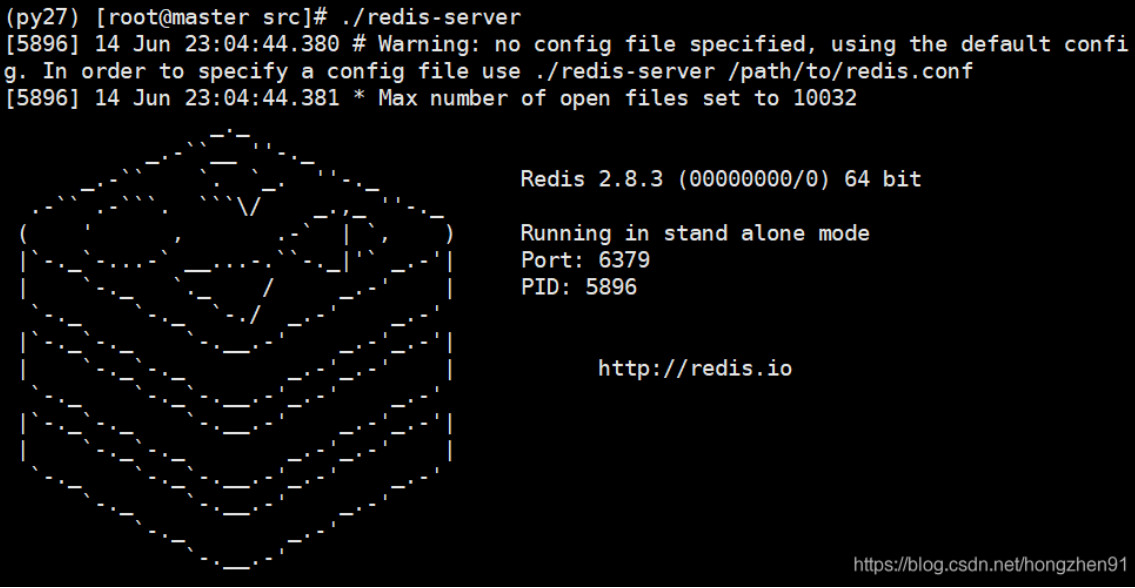

1.3、实践运行1.3.1、Redis启动redis:

1.先从一个终端启动redis服务./redis-server

2. 先从一个终端启动redis客户端,并插入数据

- ./redis-cli

- 127.0.0.1:6379> hset areas AREA_US US

- (integer) 1

- 127.0.0.1:6379> hset areas AREA_CT TW,HK

- (integer) 1

- 127.0.0.1:6379> hset areas AREA_AR PK,SA,KW

- (integer) 1

- 127.0.0.1:6379> hset areas AREA_IN IN

- (integer) 1

- 127.0.0.1:6379>

1.3.2、Kafka启动kafka:

- ./kafka-server-start.sh -daemon ../config/server.properties

kafka创建topc:

- ./kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 5 --topic allData

监控kafka topic:

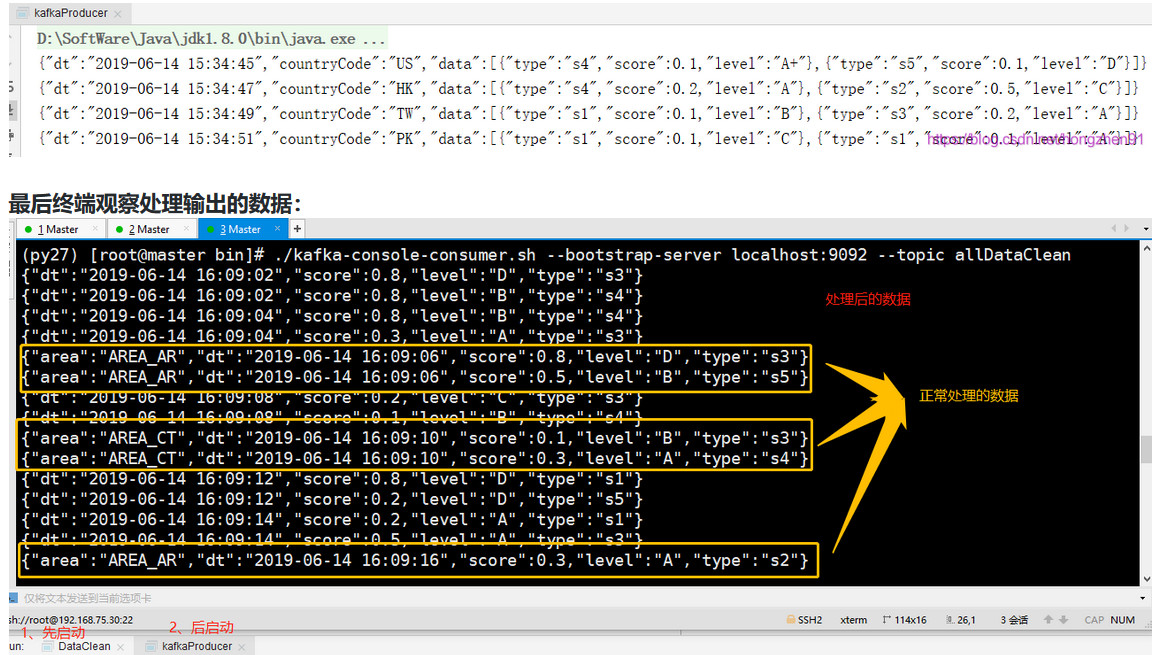

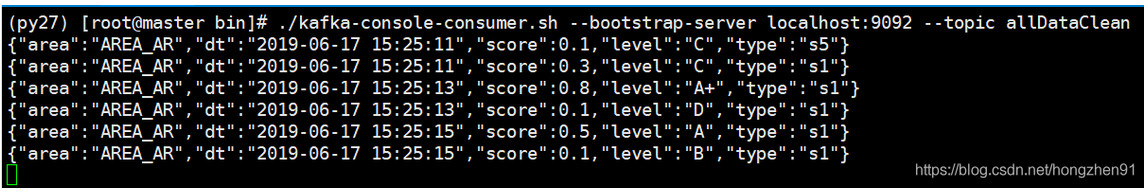

- ./kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic allDataClean

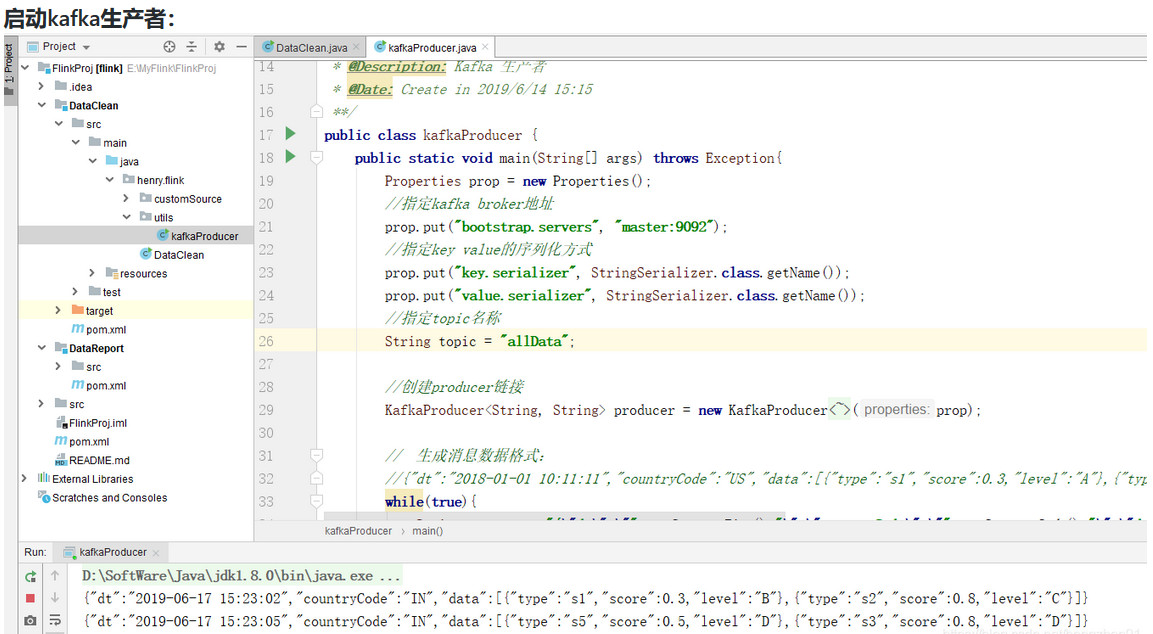

1.3.3、启动程序

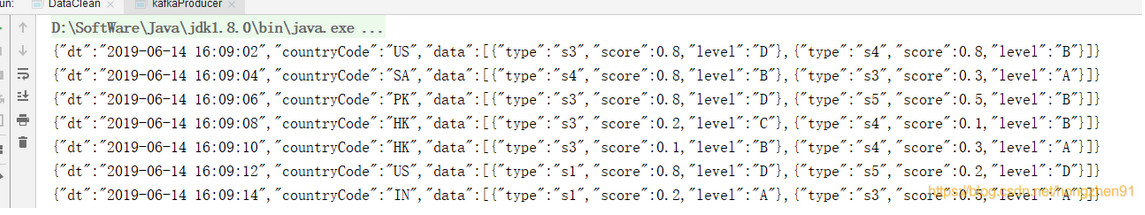

先启动 DataClean 程序,再启动生产者程序,kafka生产者产生数据如下:

只有部分数据正确处理输出的原因是:代码中没有设置并行度,默认是按机器CPU核数跑的,这里需要通过 broadcast() 进行广播

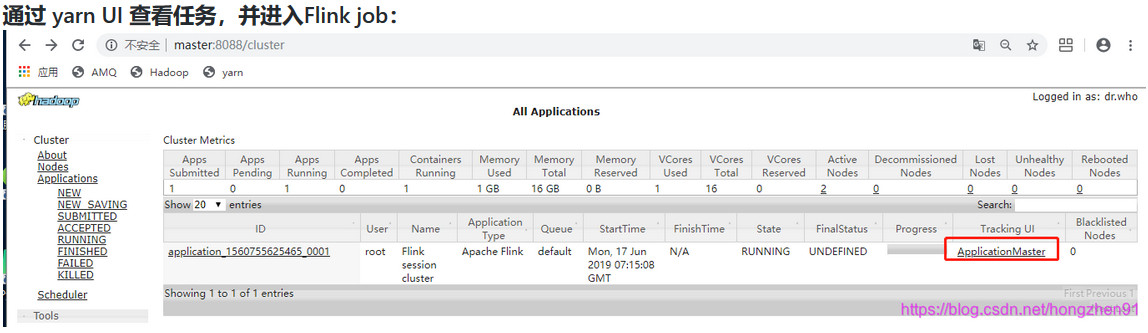

1.4、Flink yarn集群启动向yarn提交任务:

- ./bin/flink run -m yarn-cluster -yn 2 -yjm 1024 -ytm 1024 -c henry.flink.DataClean /root/flinkCode/DataClean-1.0-SNAPSHOT-jar-with-dependencies.jar

监控topic消费情况:

- ./kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic allDataClean

最终终端输出结果, 同IDEA中运行结果:

作者:HenryBao91

来源:https://github.com/HenryBao91/FlinkProj

|  /2

/2