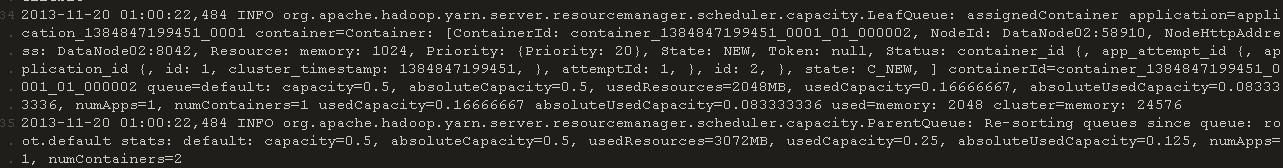

我想找到原因,接着上边的,我手动执行了同日期的 mr作业,mr作业消耗的时间吓人,然后我追踪了resourcemanager和nodemanager的日志,AM被创建到了2号datanode上

, 追到2号datanode上,查yarn-root-nodemanager-DataNode02.log,AM对container的管理和分配都还正常,但后边出现了 ,一直没看明白exit_status: -1000是什么状态,接着分析,然后会看到有那么几个container在持续 这个问题,追踪到这个container分配到的datanode上,查看yarn-root-nodemanager-DataNode03.log,确实发现出问题的container一直不能complete,反复出现 没办法,追查这个container的syslog输出,发现,此container在后期疯狂的 2181是zookeeper的clientport,不过可以确定zookeeper是正常的,因为同节点上同时还有其他的container能正常complete,并心跳回AM并汇报给resourcemanager然后我总结了下最有可能的状况,有可插入habase速度慢说的,这个container的数据量可能太大了,在操作hbase的时候阻塞了。。。,查看这个container所消耗的内存,100mb-250mb,感觉,这种量对hbase应该没什么压力呀。。。。。。所以现在迷茫了。 |  /2

/2